Cuidado con los deepfakes la nueva forma de estafa donde suplantan a famosos para manipular a víctimas

Los ciberdelincuentes utilizan deepfakes para imitar a personas famosas y engañar a las víctimas, para cometer fraude

30 abril 2025 • 04:00 pm

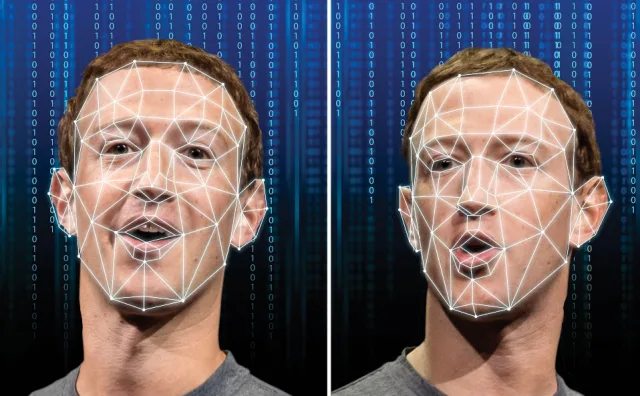

Estados Unidos. – Los fraudes en línea se han tornado más peligrosos que nunca, y ya no requieren de robar identidades… ¡las producen! Mediante el empleo de deepfakes (vídeos o audios modificados con Inteligencia Artificial para imitar de manera realista a un individuo y conseguir que exprese o realice algo que nunca sucedió), los ciberdelincuentes están simulando a famosos con el fin de obtener tu confianza y llenar sus bolsillos.

- Si pensabas que podrías confiar en lo que encuentras u oyes en internet, es hora de reflexionar sobre ello y de aprender a diferenciar entre lo falso y lo real.

Es que la utilización de esta tecnología enfrenta a numerosos internautas mexicanos, ya que, según una encuesta realizada por Kaspersky, el 72% de los participantes desconoce el significado de un deepfake y el 62% sostiene que tampoco comprende cómo identificar contenido de este tipo.

Esta carencia de conocimiento es altamente utilizada por los ciberdelincuentes, ya que las estafas a través de mensajes falsos aumentaron en 220% en México en 2024, según el Panorama de Amenazas 2024 de Kaspersky. De hecho, una de las tendencias más destacadas es la utilización de audios y videos alterados con Inteligencia Artificial.

El propósito de estos contenidos es captar la atención de usuarios de internet que, captados por imágenes de personas reconocidas que publicitan “productos milagrosos” o juegos engañosos, suelen caer en el engaño e ingresar a páginas falsas donde introducen sus datos personales y bancarios, o incluso, efectúan compras de supuestas mercancías que nunca reciben, ya que se trata de una moderna modalidad de estafa.

- Presta atención a los ojos y la boca: a menudo los deepfakes no logran reproducir los movimientos orgánicos de estos. Si el individuo parpadea escasamente o de manera inusual, o si los labios no están adecuadamente sincronizados con el sonido, podría ser un video manipulado.

- Observa con atención la iluminación y las sombras: es recomendable verificar si la luz en el rostro se asemeja a la del resto del cuerpo o el fondo donde se ha grabado el video. Las sombras que no se ajustan o los resplandores inusuales pueden provocar una alteración artificial.

- Escucha el audio con atención: un tono de voz robótico, cortes bruscos o falta de locución natural son señales de que el audio fue generado o editado con IA. Hay incluso, algunas ediciones menos cuidadosas que sobreponen un audio al sonido original que no coincide con el movimiento de los labios.

- Busca señales como: pixeles borrosos alrededor del rostro, bordes que cambian de forma o incluso gestos corporales poco naturales pueden evidenciar un deepfake malhecho.

- Verifica el origen del video: antes de dar crédito al video o de compartirlo, es importante que revises si proviene de una fuente oficial. Puedes hacerlo consultando el perfil oficial de la persona involucrada u otros medios confiables. Si se trata de un video que sólo circula en mensajes reenviados o cuentas sospechosas, ¡es falso!

Estas trampas alcanzan su propósito no solo debido a la avanzada tecnología que las sustenta, sino también porque numerosas personas todavía desconocen su presencia o desconocen cómo reconocerlas. En un mundo digital que progresa rápidamente, mantenerse actualizado acerca de la evolución de la tecnología y los peligros que conlleva— ya no es alternativa, es un método de autoprotección”, indicó Isabel Manjarrez, investigadora de seguridad del Equipo Global de Investigación y Análisis de Kaspersky.

Fuente: Agencias