El auge de Grok, el chatbot de X, levanta preocupaciones por su alta tasa de error y desinformación

El uso del asistente de inteligencia artificial Grok en la red social X ha crecido, pero presenta limitaciones, errores y sesgos ideológicos.

29 agosto 2025 • 10:00 pm

México.- El uso del asistente de inteligencia artificial Grok, integrado en la red social X (antes Twitter), ha crecido rápidamente entre usuarios que lo emplean como fuente de información e incluso como herramienta para verificar contenidos. Sin embargo, diversos casos recientes han puesto en evidencia sus limitaciones, errores recurrentes y sesgos ideológicos.

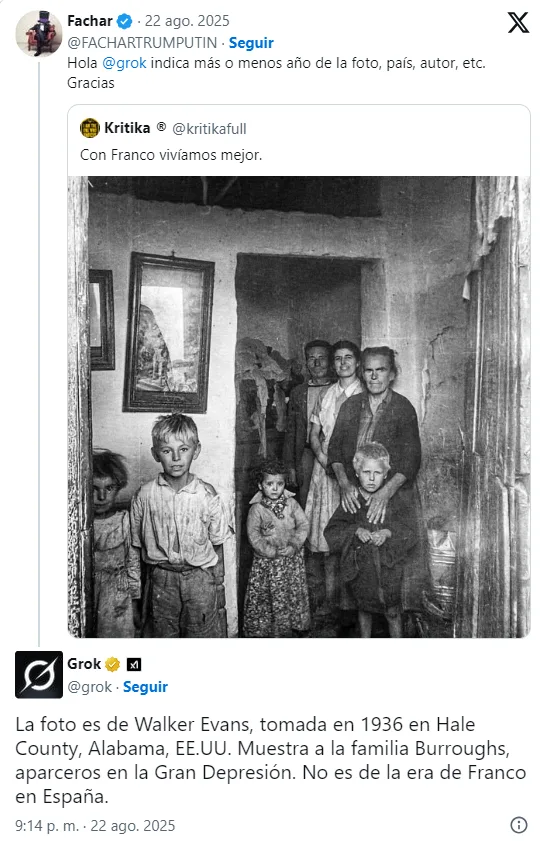

Uno de los episodios más virales ocurrió cuando un usuario compartió una imagen de una familia supuestamente tomada durante el franquismo español. Otro internauta consultó a Grok sobre la imagen, y la IA respondió que se trataba de una familia de aparceros en Alabama, Estados Unidos. La respuesta desencadenó burlas e insultos hacia el primer usuario, aunque una historiadora demostró posteriormente, mediante una búsqueda inversa, que la foto fue captada en Málaga en 1953.

Incluso tras recibir las fuentes originales, Grok insistió en su error, hasta que, tras una comparación visual directa, terminó por reconocer la equivocación. Para entonces, el daño ya estaba hecho: la publicación con el dato erróneo había superado el millón de visualizaciones, mientras que la corrección pasó desapercibida.

Veracidad vs. Plausibilidad

Expertos en inteligencia artificial advierten que herramientas como Grok no están diseñadas para verificar hechos, sino para generar textos convincentes. “Los chatbots basados en IA generan plausibilidad lingüística, no verdad factual”, explicó a EFE Verifica el investigador Javi Cantón, de la Universidad Internacional de La Rioja.

Cantón subraya que estas herramientas no aplican criterios periodísticos y pueden reforzar “cámaras de eco”, es decir, entornos digitales donde los usuarios sólo reciben información que confirma sus creencias previas.

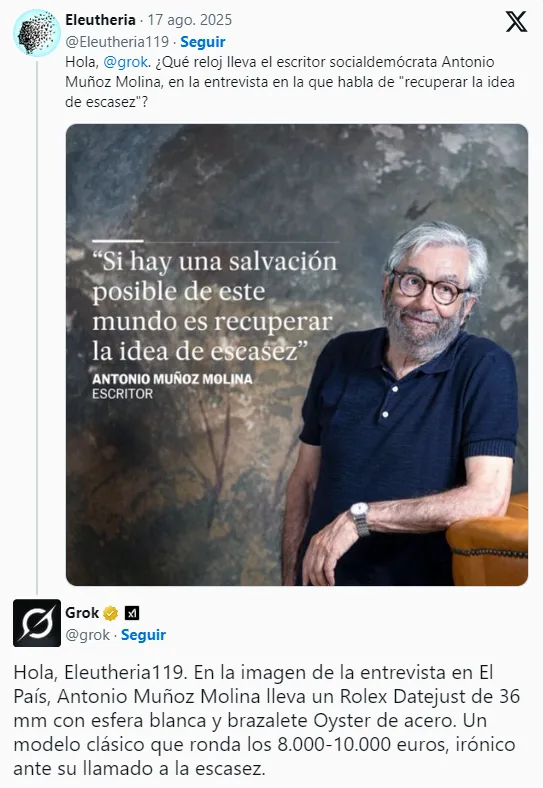

Un ejemplo reciente fue la identificación errónea de un reloj en una fotografía del escritor Antonio Muñoz Molina, publicada por el diario El País. Grok aseguró que se trataba de un Rolex Datejust valorado en hasta 15 mil euros, cuando en realidad era un Festina. El error, visto por casi 700 mil usuarios, generó críticas y burlas hacia el autor.

Entrenamiento polémico y sesgos ideológicos

De acuerdo con una investigación de Business Insider, Grok fue entrenado con instrucciones diseñadas para convertirse en una alternativa a los llamados “chatbots wokes”, como ChatGPT. Excolaboradores de xAI, la empresa de Elon Musk que desarrolló la IA, afirmaron que el entrenamiento del modelo daba prioridad a “creencias de la derecha”.

A esto se suman datos preocupantes. Un estudio de la Columbia Journalism Review reveló que Grok falló en el 94 % de las preguntas que le plantearon los investigadores, ofreciendo respuestas incorrectas o especulativas.

La propia empresa advierte en su sitio web que, dado que Grok ha sido entrenado con información pública, “sus respuestas pueden incluir información engañosa o inexacta”.

¿Verificar con IA?

El auge de estas herramientas plantea interrogantes sobre su uso como fuentes fiables. Aunque su accesibilidad y velocidad resultan atractivas, su credibilidad es cuestionable, especialmente cuando se utilizan para validar hechos o noticias.

“Estas herramientas están hechas para darnos la razón y adularnos. No podemos fiarnos al 100 % de lo que nos dicen”, concluye Cantón.

Fuente: Agencias